Die Kunst des Prompt Engineerings

In der Interaktion mit KI-gesteuerten Systemen sind Prompts, also die Eingaben in natürlicher Sprache, von entscheidender Bedeutung. Sie sind die Brücke zwischen Mensch und Maschine und beeinflussen maßgeblich die Qualität und Präzision der Antworten. Erfahren Sie in diesem Artikel, wie Sie mit Prompt Engineering die Leistung von Large Language Models (LLMs) beeinflussen und das Beste aus KI-gesteuerten Interaktionen herausholen können.

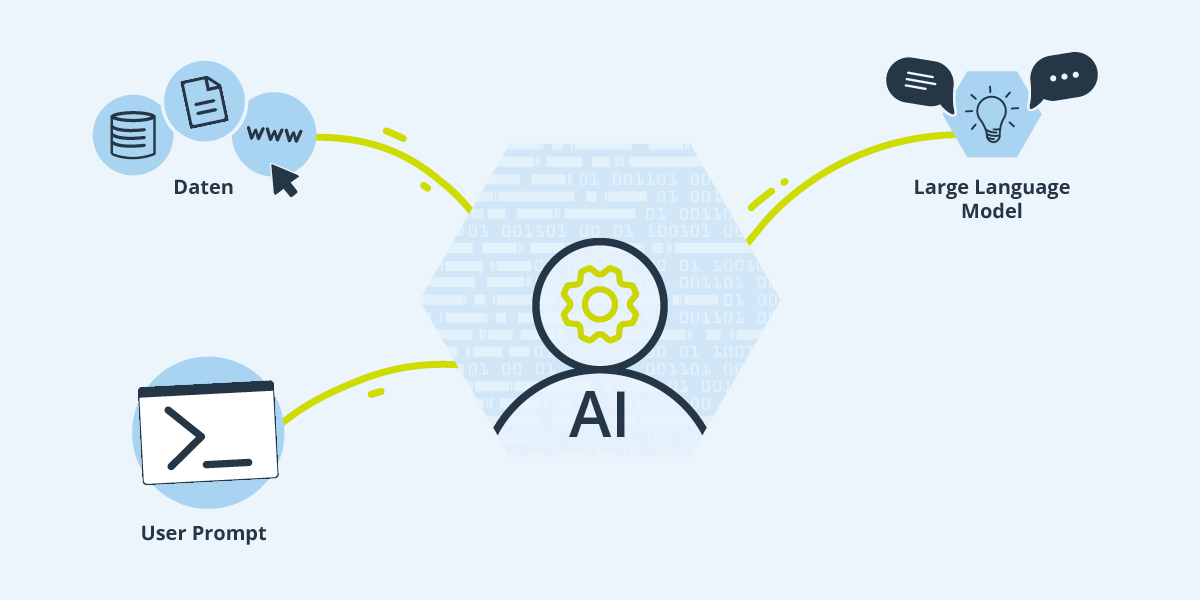

Prompt Engineering bezeichnet das strategische Verfassen und Optimieren von Prompts, um die Leistungsfähigkeit und Genauigkeit von KI-Modellen, insbesondere Large Language Models (LLMs), zu verbessern. Ein Prompt ist im Wesentlichen die Anfrage des Users an die KI in natürlicher Sprache, ohne die Notwendigkeit, komplexe Codes zu verwenden. Die KI analysiert den Prompt und generiert eine entsprechende Antwort. Obwohl die KI auf riesige Mengen an Daten zugreift, hängt die Qualität der Ergebnisse maßgeblich von der Eingabe des Prompts ab.

OpenAI-Gründer Sam Altman schrieb im Februar auf Twitter : „Einen großartigen Prompt für einen Chatbot zu schreiben, ist eine unglaublich hohe Fähigkeit und ein frühes Beispiel dafür, in natürlicher Sprache zu programmieren.“

Wie denkt die Künstliche Intelligenz?

Um zu verstehen, wie Prompt Engineering funktioniert, ist es hilfreich zu verstehen, wie LLMs ihre Antworten generieren. Die Datenmenge, auf die ein LLM zugreift, kann als riesige "Bibliothek" voller Informationen betrachtet werden. Die KI analysiert, welche Buchstaben in dieser Bibliothek oft aufeinanderfolgen, und errechnet daraus Wahrscheinlichkeiten für Buchstaben- bzw. Wortkombinationen. Anhand dieser Statistik stellt die KI ein Wortmuster auf, ohne den Inhalt wirklich zu verstehen.

Basic Prompts

Ein einfacher Prompt kann bereits ein sinnvolles Ergebnis erbringen, das jedoch nicht der Erwartungshaltung entspricht. Auf unklare Prompts kann es mehrere Antworten geben. Der Prompt „Der Himmel ist“ kann beispielsweise eine Definition des Begriffs „Himmel“ oder eine Beschreibung des Himmels wie „Der Himmel ist blau.“ ausgeben.

Es gibt verschiedene Ansätze und Techniken im Prompt Engineering, um die KI in die gewünschte Antwortrichtung zu lenken.

Style Guidance

Beim Prompt Engineering werden der KI mehr Details bereitgestellt. Um z.B. das gewünschte Ausgabeformat zu erhalten, ist es wichtig, konkrete Style Guidance zu geben. Hierzu gehören Angaben zur gewünschten Tonalität, beispielsweise freundlich oder fachlich, sowie zum Format der Antwort, wie etwa Bullet Points oder Interview, oder der Länge wie „2 bis 3 Sätze“ oder „maximal 500 Zeichen“.

Role Prompting

Beim Role Prompting wird die KI in eine bestimmte Rolle versetzt, um den Kontext der Interaktion klarer zu definieren und präzisere Ergebnisse zu liefern. Typische Formulierungen sind: "Agiere als Kundenservice-Mitarbeitender" oder "Stell dir vor, du bist ein Experte im Alter von … für das Thema … mit einem Master-Studium in …".

Few Shot Prompting

Beispiele für gelungene Ergebnisse zu ähnlichen Anfragen werden der KI vom User beim Few Shot Prompting gegeben. Typische Formulierungen für das Prompt Engineering wären in diesem Fall: "Orientiere dich am folgenden Beispiel". Anhand des Beispiels erhält die KI eine Vorlage, nach deren Schema sie ihre Antwort anpasst.

Chain of Thought Prompting

Das Chain of Thought Prompting entspricht dem Few Shot Prompting, aber es wird um eine Erklärung ergänzt, weshalb sich die eingefügten Beispiele besonders gut für die Antwort eignen. Die KI erhält durch diese Form des Prompt Engineering eine genauere Anleitung, worauf sie bei der Antwort achten sollte.

Selbstkonsistenz

Damit die KI die Wahrscheinlichkeit erhöhen kann, dass ihre Antwort konsistent ist, können mehrere Chain of Thought Prompt-Beispiele in die eigentliche Aufgabe inkludiert werden. Bei diesem Ansatz werden dem Sprachmodell mehrere Frage-Antwort- oder Eingabe-Ausgabe-Paare zur Verfügung gestellt, die den Lösungsprozess in den gegebenen Antworten oder Ausgaben erklären. Anschließend kann die KI anhand dieser Beispiele, die neue Aufgabe nach einem ähnlichen Prozess lösen.

Schwächen und Risiken eines Large Language Models

Trotz aller Tipps und Techniken zum Prompt Engineering erzeugt die KI auch fehlerhafte oder ungenaue Antworten, da sie ihr Wissen aus einem von Menschen geschaffenen Trainingssatz bezieht, der möglicherweise fehlerhafte oder veraltete Informationen enthält. Darüber hinaus kann die KI Probleme haben, sinnvolle Kontexte zu erkennen. Subtile oder komplexe Fragen oder auch Stilmittel wie Ironie oder Sarkasmus können von der KI missverstanden werden.

Die KI neigt auch dazu, zu "übervertrauen", indem sie Antworten erzeugt, die sich plausibel anhören, aber faktisch nicht korrekt sind. Man spricht in diesem Fall von Halluzinationen der KI. Zudem besteht das Risiko, dass sie voreingenommene oder unangemessene Inhalte reproduziert, da sie ihre Antworten aufgrund des Trainingsdatensatzes generiert, der menschliche Vorurteile und unerwünschte Inhalte enthalten kann.

Diese Schwächen machen es wichtig, die Ausgaben von Large Language Models kritisch zu prüfen und sie nicht blind als absolut zuverlässige Quellen anzusehen.

Weitere Beiträge aus der Kategorie "B2B Markt"